ક્રિકેટના વર્લ્ડકપનો ઉન્માદ જો ઓસરી ગયો હોય તો આજે મજાક લાગતી, પણ આવતીકાલે સમાજ માટે ભયાવહ  સાબિત થનાર એક ટેકનોલોજી વિશે વાત કરવી છે. એ ટેકનોલોજીનું નામ તો તમે આજકાલ છાપાઓમાં વાંચતા જ હશોઃ ડીપફેક ટેકનોલોજી.

સાબિત થનાર એક ટેકનોલોજી વિશે વાત કરવી છે. એ ટેકનોલોજીનું નામ તો તમે આજકાલ છાપાઓમાં વાંચતા જ હશોઃ ડીપફેક ટેકનોલોજી.

યાદ હોય તો હમણાં વડાપ્રધાન નરેન્દ્ર મોદી બહેનો સાથે ગરબે ઘૂમતા હોય એવો એક વિડીયો વાઇરલ થયેલો. વિડીયો જોતાં પહેલી નજરે તો એ અદ્દલોદલ નરેન્દ્રભાઇ જ લાગે એટલે કાયમ ચાપલૂસી માટે તૈયાર એવા ભાજપના કેટલાક (અતિ) ઉત્સાહી કાર્યકરો-અગ્રણીઓએ તો એ વિડીયો પોતાના તરફથી સોશિયલ મિડીયામાં મૂકી ય દીધો, પણ પછી ખુદ નરેન્દ્રભાઇએ ફોડ પાડવા પડ્યો કે, એ વિડીયોમાં હું નથી, કોઇએ નકલી વિડીયો બનાવ્યો છે!

બસ, આ નકલી વિડીયો એટલે ડીપફેક ટેકનોલોજી. એમ તો, થોડાક દિવસ પહેલાં અભિનેત્રી રશ્મિકા મંદાનાનો પણ આવો જ એક ફેક વિડીયો વાઇરલ થયો ત્યારે ય હોહા મચી ગયેલી. આ વિડીયો પણ ડીપફેક ટેકનોલોજીની જ ‘ભયાનક કમાલ’ હતી. ફોટોશોપની મદદથી એક વ્યક્તિના ચહેરા પર બીજાનો ચહેરો લગાડવાના કે તસવીરનું બેકગ્રાઉન્ડ બદલીને નકલી ઇમેજીઝ બનાવવાના દિવસો ગયા. હવે તો વ્યક્તિના અસલી વિડીયો અને અસલી અવાજ વાપરી બનાવટી વિડીયો બનાવીને એના મુખે બનાવટી શબ્દો મૂકી શકો એ દિવસો આવ્યા છે. આપણે જેને આર્ટીફિશ્યલ ઇન્ટેલિજન્સ એટલે કે એઆઇ કહીએ છીએ એની શેતાની બાયપ્રોડ્કટ એટલે ડીપફેક ટેકનોલોજી.

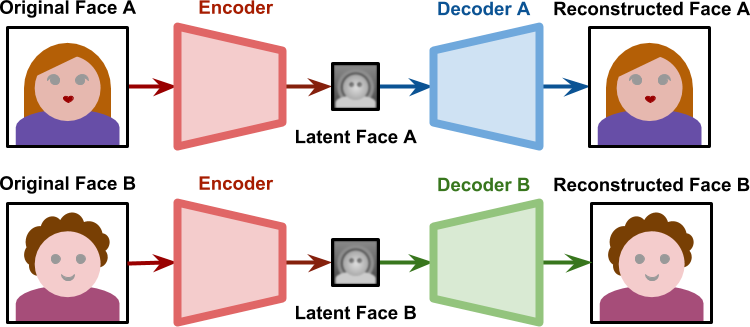

સાદી ભાષામાં સમજીએ તો, ડીપફેક એ ફોટોશોપથી એક-બે નહીં, અનકે ડગલાં આગળ એવી ટેકનોલોજી છે, જેમાં એઆઇના ડીપ લર્નિંગનો ઉપયોગ કરીને નકલી વિડીયો બનાવી શકાય છે. પાવરફૂલ ગ્રાફીક્સ ધરાવતા હાઇએન્ડ કમ્પ્યુટરની મદદથી તમે કોઇપણ વ્યક્તિની ઇમેજ બનાવી શકો છો. એના વિડીયો ક્રિએટ કરી શકો છો. તદ્દન કાલ્પનિક ચહેરો બનાવીને એના નામના સોશિયલ મિડીયા એકાઉન્ટ્સ પણ ક્રિએટ કરી શકો છો. પહેલાં એઆઇ અલ્ગોરિધમ એન્કોડરની મદદથી બે વ્યક્તિની ઇમેજના અનેકગણા શોટ્સ ક્રિએટ કરવામાં આવે છે. એ પછી એઆઇ બંને ઇમેજમાં રહેલી સામ્યતાને ઓળખી લે છે અને પછી એમાંથી પ્રોસેસ કરેલી ઇમેજને ડીકોડરની મદદથી નવી ઇમેજ ક્રિએટ કરાય છે.

વર્ષ 2017માં રેડિટના એક યુઝરે ગેલ ગેડોટ, ટેલર સ્વીફ્ટ, સ્કાર્લેટ જોન્સન જેવી સેલેબ્રિટીઓના ચહેરાઓ સાથે એક પોર્નોગ્રાફીક વિડીયો ક્લિપ પોસ્ટ કરી એ પછી આ ટેકનોલોજી ચર્ચામાં આવી. આપણે ત્યાં પણ અગાઉ 2020માં દિલ્હી ભાજપના નેતા મનોજ તિવારીનો હિન્દી અને હરિયાણવીમાં બોલતા હોય એવા બે બનાવટી વિડીયો બહાર આવેલા. બરાક ઓબામા, ડોનાલ્ડ ટ્રમ્પ, પુતીન, માર્ક ઝુકરબર્ગ પણ ડીપફેકની ઝપેટમાં આવી ચૂક્યા છે. જાણીતા લોકો એનો શિકાર બને એના બે કારણ છેઃ એક તો, આવા લોકોના વિડીયોઝ અને ઇમેજીઝ ઇન્ટરનેટ પર આસાનીથી મળી જાય છે અને બે, સેલેબ્રિટીઓના કારણે જ આવા વિડીયો વાઇરલ થાય છે, સોશિયલ મિડીયા સેન્સેશન ક્રિએટ કરી શકાય છે.

ડીપફેક એ ભવિષ્યમાં કેટલું ખતરનાક પૂરવાર થઇ શકે છે એનો ખ્યાલ જ બિહામણું ચિત્ર ઉપસાવે છે. વડાપ્રધાન નરેન્દ્ર મોદીએ કાંઇ એમને એમ જ એની ગંભીરતા તરફ આંગળી નથી ચીંધી. કેન્દ્ર સરકારે પણ સોશિયલ મિડીયા પ્લેટફોર્મ્સને આ દિશામાં કડક ચેતવણી આપીને આઇટી રૂલ્સમાં કડક બદલાવના નિર્દેશ આપ્યા છે. એની ગંભીરતા સમજવા બે જ બાબત વિચારવી પર્યાપ્ત છેઃ

એકઃ ફેક ન્યૂઝની માફક ડીપફેકનો પણ ચૂંટણીમાં બેફામ ઉપયોગ. આજે નરેન્દ્ર મોદીનો વિડીયો બન્યો તો આવતીકાલે રાહુલ ગાંધીનો ય વિડીયો બની શકે છે. ચૂંટણીના સમયે એકબીજાને બદનામ કરવા વિરોધી નેતાના મુખે કાંઇપણ બોલાવીને કે એ ક્ષોભજનક સ્થિતિમાં મૂકાય એવા વિડીયો વાઇરલ કરી શકાય છે. સામાન્ય ટેકનોલોજીથી મોર્ફ કરેલા ફોટોગ્રાફ્સ કે વિડીયો કરતાં ડીપફેક અનેકગણા વાસ્તવિક લાગ છે અને સામાન્ય લોકો માટે એ ડીપફેક છે એ ઓળખવું મુશ્કેલ હોય છે. દરેક રાજકીય પક્ષ પોતાના આઇટી સેલની મદદથી આવા વિડીયો વાઇરલ કરવા માંડે તો જે અંધાધૂંધી સર્જાય એની કલ્પના કરી લો. હાર-જીત જેની થાય એની, પણ સરવાળે તો એમાં લોકો અને લોકશાહી જ હારશે.

બેઃ સપ્ટેમ્બર, 2019માં એઆઇ કંપની ડીપટ્રેસે ડીપફેકથી બનેલા 15000 થી વધારે વિડીયો શોધ્યા હતા એમાંથી લગભગ 96 ટકા વિડીયો પોર્નોગ્રાફીક હતા! રશ્મિકા મંદાનાનો ડીપફેક વિડીયો તો આની સરખામણીએ કાંઇ ન કહેવાય (અફકોર્સ, એ પણ સાંખી લેવા જેવું કૃત્ય તો નથી જ), પણ આ વાત સમાજ સામે લાલબત્તી તો છે જ. જેમ આ ટેકનોલોજી વધારે સુગમ બનતી જશે એમ સેલેબ્રિટી મહિલાઓ એનો વધારે આસાનીથી શિકાર બનતી જશે. કોઇપણ મહિલાને બદનામ કરવા માટે ડીપફેક હાથવગું સાધન બની શકે છે.

વિચાર કરો, હજુ આપણે ફેક ન્યૂઝના દૂષણને અટકાવી શક્યા નથી એમાં ડીપફેકનો ખતરો માથે તોળાઇ રહ્યો છે. એને નાથવાની ટેકનોલોજી તો શોધાય ત્યારે, પણ હાલ તો ઇન્ટનેટ અને સોશિયલ મિડીયા યુઝર તરીકે આપણી પુખ્તતા અને સમજદારી જ એમાંથી બચાવી શકે છે. બાકી તો એવું છે ને કે, રોક સકો તો રોક લો!

(લેખક ચિત્રલેખા.કોમ ના એડિટર છે.)